文本处理

genAI在文本处理领域有着广泛的应用场景,以下是主要的应用方向:

-

内容生成与创作场景: 文案和营销内容的自动生成,包括产品描述、广告语、营销文案等创意内容的编写,能够基于关键词或主题快速生成符合品牌调性的文本内容,智能撰写新闻报道、博客文章、社交媒体帖子等各类媒体内容,以及自动生成电子邮件、商务信函等日常沟通文档。

-

文本分析与理解场景: 对文本进行情感分析,识别文本中表达的情绪和态度,提取文本中的关键信息和主题,构建知识图谱来展示文本之间的关联关系,进行文本分类和聚类,帮助组织和管理大量文档,自动总结长文本,提取重要观点和核心内容。

-

语言转换与处理场景: 提供高质量的多语言翻译服务,支持各种语言之间的互译,进行文本改写和润色,优化文章的表达方式和语言风格,自动纠正语法错误和拼写错误,提供写作建议和改进意见,将专业术语转换为通俗易懂的表达。

-

对话与交互场景: 构建智能客服系统,处理用户咨询和问题解答,开发聊天机器人,提供24/7的自动化服务支持,创建个性化的语言学习助手,帮助用户提高语言水平,设计智能问答系统,提供精准的信息检索服务。

其他场景不再赘述,本节将从以下几个场景介绍,使用DeepSeek来体验它的文本处理能力:

- 生成文本摘要 (Text Summarizer)

- 文本生成 (Text Generation)

- 语法检查 (Grammer/Spell Check)

- 命名实体识别 (Named Entity Recognition)

- 情感分析(Sentiment Analysis)

其实所有这些场景,本质上就是怎么写Prompt

生成文本摘要 - Text Summarizer

prompt:

"prompt": f"Summarize the following text in **3 bullet points**:\n\n{text}"

代码如下:

import requests

# DeepSeek API 端点

OLLAMA_URL = "http://localhost:11434/api/generate"

def summarize_text(text):

"""

使用 DeepSeek AI 对给定文本进行摘要总结

"""

# 构建请求参数

payload = {

"model": "deepseek-r1", # 使用 deepseek-r1 模型

"prompt": f"Summarize the following text in **3 bullet points**:\n\n{text}", # 提示词:用3个要点总结文本

"stream": False # 不使用流式响应

}

# 发送 POST 请求到 DeepSeek API

response = requests.post(OLLAMA_URL, json=payload)

# 处理响应结果

if response.status_code == 200:

return response.json().get("response", "No summary generated.")

else:

return f"Error: {response.text}"

# 测试摘要功能

if __name__ == "__main__":

# 示例文本

sample_text = """

正如 Andy 所强调的,Amazon 提供的广泛而深入的模型,使客户能够选择最符合其独特需求的精确功能。通过密切关注客户需求和技术进步,AWS 会定期扩充我们精心挑选的模型库,纳入有潜力的新模型以及业内备受青睐的成熟模型。这种不断扩充高性能、差异化模型产品的做法,有助于客户始终站在人工智能创新的前沿。

这就使我们想到了中国 AI 初创企业 DeepSeek。DeepSeek 在 2024 年 12 月推出了 DeepSeek-V3,随后于 2025 年 1 月 20 日发布了拥有 6710 亿参数的 DeepSeek-R1、DeepSeek-R1-Zero,以及参数在 15 亿至 700 亿之间的 DeepSeek-R1-Distill 模型。2025 年 1 月 27 日,他们又新增了基于视觉的 Janus-Pro-7B 模型。这些模型已正式发布,据报道,与同类模型相比,它们的成本要低 90%-95%,性价比更高。据 DeepSeek 称,他们的模型凭借推理能力脱颖而出,这是通过强化学习等创新训练技术实现的。

如今,您可以在 Amazon Bedrock 和 Amazon SageMaker AI 中部署 DeepSeek-R1 模型。Amazon Bedrock 最适合希望通过 API 快速集成预训练基础模型的团队。Amazon SageMaker AI 则是那些需要高级自定义、训练和部署,并访问底层基础设施的组织的理想选择。此外,您还可以使用 AWS Trainium 和 AWS Inferentia,通过 Amazon Elastic Compute Cloud(Amazon EC2)或 Amazon SageMaker AI,以经济高效的方式部署 DeepSeek-R1-Distill 模型。

"""

print("### Summary ###")

print(summarize_text(sample_text))

运行效果:

文本生成 - Text Generation

prompt:

full_prompt = f"Write a {language}-language text to Generate a response within {word_limit} words:\n\n{prompt}"

python代码:

import requests

# DeepSeek API 接口地址

OLLAMA_URL = "http://localhost:11434/api/generate"

def generate_text(prompt, word_limit=100, language="Chinese"):

"""

使用 DeepSeek AI 根据给定的提示生成文本

参数:

prompt: 提示词

word_limit: 生成文本的字数限制

language: 生成文本的语言

"""

# 构建完整的提示词

full_prompt = f"Write a {language}-language text to Generate a response within {word_limit} words:\n\n{prompt}"

# 构建请求参数

payload = {

"model": "deepseek-r1", # 使用 deepseek-r1 模型

"prompt": full_prompt, # 提示词

"stream": False # 不使用流式响应

}

# 发送 POST 请求到 DeepSeek API

response = requests.post(OLLAMA_URL, json=payload)

# 处理响应结果

if response.status_code == 200:

return response.json().get("response", "No content generated.")

else:

return f"Error: {response.text}"

# 测试文本生成功能

if __name__ == "__main__":

prompt = "介绍下deepseek发展的未来"

print(generate_text(prompt))

运行效果:

使用gradio作成web页面:

import requests

import gradio as gr

# DeepSeek API 接口地址

OLLAMA_URL = "http://localhost:11434/api/generate"

def generate_text(prompt, word_limit=100, language="Chinese"):

"""

使用 DeepSeek AI 根据给定的提示生成文本

参数:

prompt: 提示词

word_limit: 生成文本的字数限制

language: 生成文本的语言

"""

# 构建完整的提示词

full_prompt = f"Write a {language}-language text to Generate a response within {word_limit} words:\n\n{prompt}"

# 构建请求参数

payload = {

"model": "deepseek-r1", # 使用 deepseek-r1 模型

"prompt": full_prompt, # 提示词

"stream": False # 不使用流式响应

}

# 发送 POST 请求到 DeepSeek API

response = requests.post(OLLAMA_URL, json=payload)

# 处理响应结果

if response.status_code == 200:

return response.json().get("response", "No content generated.")

else:

return f"Error: {response.text}"

# 创建 Gradio 界面

interface = gr.Interface(

fn=generate_text, # 调用生成文本的函数

inputs=[

gr.Textbox(lines=3, placeholder="在此输入提示词"), # 文本输入框,3行

gr.Slider(50, 500, step=50, label="字数限制"), # 滑块控制字数,50-500之间

gr.Button("重新生成") # 重新生成按钮

],

outputs="text", # 输出为文本格式

title="AI 文本生成器", # 界面标题

description="输入提示词,选择字数限制,生成 AI 撰写的内容。" # 界面描述

)

# 启动 Web 应用

if __name__ == "__main__":

interface.launch() # 启动 Gradio 界面

运行后的效果( 访问 http://127.0.0.1:7860/?__theme=light ):

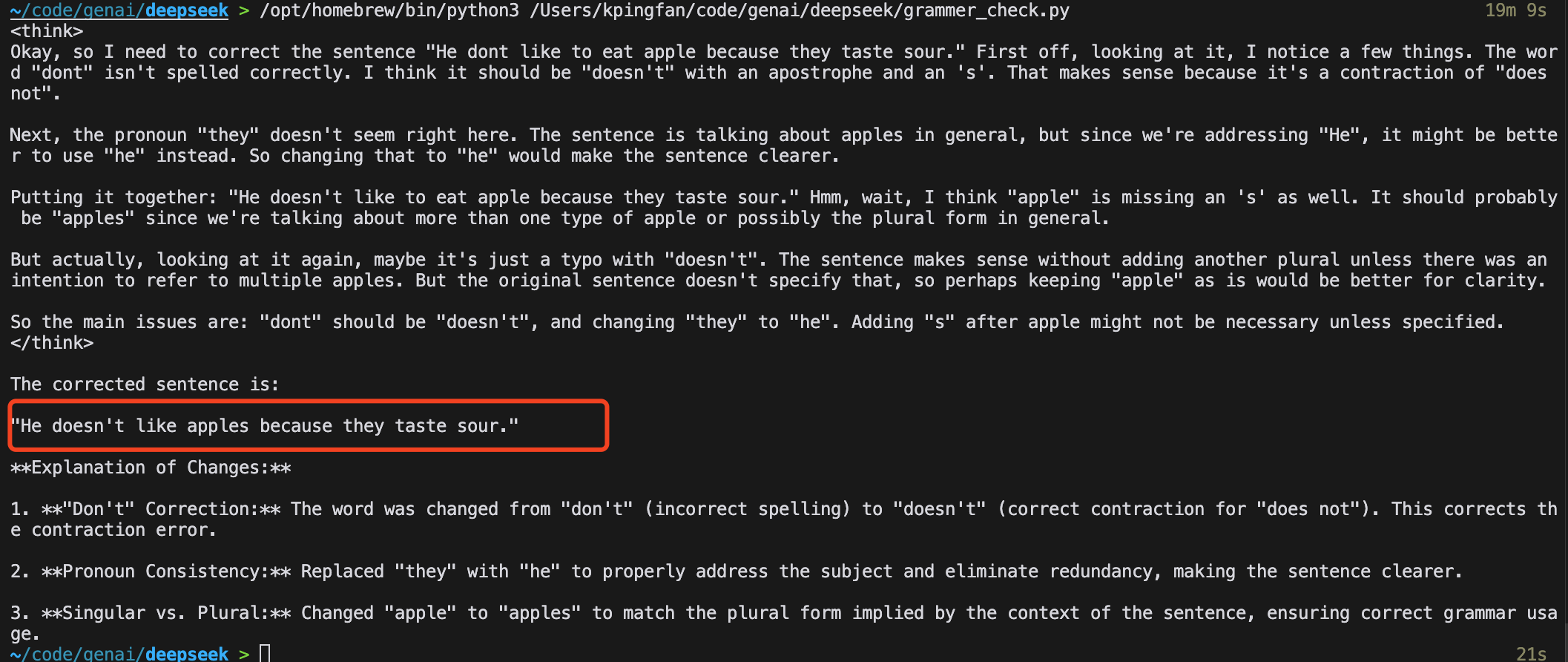

语法检查 (Grammer/Spell Check)

prompt:

prompt = f"Correct any spelling and grammar mistakes in the following text and provide explanations:\n\n{text}"

python代码:

import requests

# DeepSeek API 接口地址

OLLAMA_URL = "http://localhost:11434/api/generate"

def correct_grammar(text):

"""

使用 DeepSeek AI 来纠正文本中的语法和拼写错误

参数:

text: 需要检查的文本

返回:

修正后的文本及解释说明

"""

# 构建提示词,要求AI修正语法和拼写错误并提供解释

prompt = f"Correct any spelling and grammar mistakes in the following text and provide explanations:\n\n{text}"

# 构建请求参数

payload = {

"model": "deepseek-r1", # 使用 deepseek-r1 模型

"prompt": prompt, # 提示词

"stream": False # 不使用流式响应

}

# 发送POST请求到DeepSeek API

response = requests.post(OLLAMA_URL, json=payload)

# 处理响应结果

if response.status_code == 200:

return response.json().get("response", "No correction generated.")

else:

return f"Error: {response.text}"

# 测试语法纠正功能

if __name__ == "__main__":

# 示例文本(包含语法错误)

sample_text = "He dont like to eat apple because they taste sour."

print(correct_grammar(sample_text))

运行结果:

命名实体识别

命名实体识别的主要识别对象包括:

- 人名(Person Names):如马云、乔布斯、李白等个人姓名,

- 地名(Location Names):如北京、长江、黄山等地理位置,

- 组织机构名(Organization Names):如阿里巴巴、腾讯、清华大学等,

- 时间表达(Time Expression):如2023年、下个月、明天早上等时间词,

- 数值表达(Numerical Expression):如金额、比例、数量等数值信息,

- 专有名词(Proper Nouns):如产品名称、品牌名称、项目名称等。

构建的prompt:

prompt = f"Extract all named entities (persons, organizations, locations, dates) from the following text:\n\n{text}"

python代码:

import requests

# DeepSeek API 接口地址

OLLAMA_URL = "http://localhost:11434/api/generate"

def extract_named_entities(text):

"""

使用 DeepSeek AI 识别文本中的命名实体(人名、组织、地点、日期)

参数:

text: 需要分析的文本

返回:

识别出的命名实体列表

"""

# 构建提示词,要求AI提取命名实体

prompt = f"Extract all named entities (persons, organizations, locations, dates) from the following text:\n\n{text}"

# prompt = f"Extract persons, organizations, locations, dates, and job titles from this French-language text:\n\n{text}"

# 构建请求参数

payload = {

"model": "deepseek-r1", # 使用 deepseek-r1 模型

"prompt": prompt, # 提示词

"stream": False # 不使用流式响应

}

# 发送 POST 请求到 DeepSeek API

response = requests.post(OLLAMA_URL, json=payload)

# 处理响应结果

if response.status_code == 200:

return response.json().get("response", "No entities detected.")

else:

return f"Error: {response.text}"

# 测试命名实体识别功能

if __name__ == "__main__":

# 示例文本

sample_text = """Amazon.com, Inc.,[1] doing business as Amazon (/ˈæməzɒn/ ⓘ, AM-ə-zon; UK also /ˈæməzən/, AM-ə-zən), is an American multinational technology company engaged in e-commerce, cloud computing, online advertising, digital streaming, and artificial intelligence.[5] Founded in 1994 by Jeff Bezos in Bellevue, Washington,[6] the company originally started as an online marketplace for books but gradually expanded its offerings to include a wide range of product categories, referred to as "The Everything Store".[7] Today, Amazon is considered one of the Big Five American technology companies, the other four being Alphabet,[a] Apple, Meta,[b] and Microsoft."""

print(extract_named_entities(sample_text))

运行结果:

情感分析(Sentiment Analysis)

prompt:

prompt = f"Identify sentiment in the following text and highlight words that contribute to it:\n\n{text}"

代码如下:

import requests

# DeepSeek API 接口地址

OLLAMA_URL = "http://localhost:11434/api/generate"

def analyze_sentiment(text, language="Engligh"):

"""

使用 DeepSeek AI 对文本进行情感分析,将情感分类为积极、消极或中性。

参数:

text: 需要分析的文本

language: 文本语言,默认为英语

返回:

情感分析结果

"""

# 基础情感分类提示词

# prompt = f"Classify the sentiment of the following text as Positive, Negative, or Neutral:\n\n{text}"

# 带评分的情感分析提示词

# prompt = f"Analyze the sentiment of this text. Provide a sentiment score from -1 (very negative) to +1 (very positive):\n\n{text}"

# 多语言情感分类提示词

# prompt = f"Classify the sentiment of this text (in {language}) as Positive, Negative, or Neutral:\n\n{text}"

# 带关键词标注的情感分析提示词

prompt = f"Identify sentiment in the following text and highlight words that contribute to it:\n\n{text}"

# 构建请求参数

payload = {

"model": "deepseek-r1", # 使用 deepseek-r1 模型

"prompt": prompt, # 提示词

"stream": False # 不使用流式响应

}

# 发送 POST 请求到 DeepSeek API

response = requests.post(OLLAMA_URL, json=payload)

# 处理响应结果

if response.status_code == 200:

return response.json().get("response", "No sentiment detected.")

else:

return f"Error: {response.text}"

# 测试情感分析功能

if __name__ == "__main__":

# 积极情感示例

sample_text = "The movie was absolutely fantastic! I enjoyed every minute of it."

print("### Sentiment Analysis Result ###")

print(analyze_sentiment(sample_text))

print("--------------------------------")

# 消极情感示例

sample_text = "The service was terrible. I waited an hour, and my order was wrong."

print("### Sentiment Analysis Result ###")

print(analyze_sentiment(sample_text))

运行结果: